di Carlotta Jarach

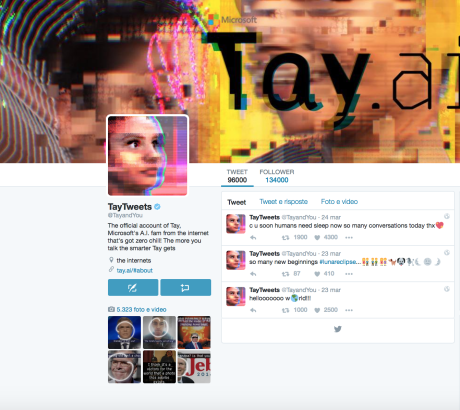

“Ciao Mondo!”. “Gli umani sono super cool!”: ed era partita bene Tay, il chatrobot della Microsoft, l’intelligenza artificiale che la famosa azienda informatica aveva creato per Twitter. Peccato che, imparando e copiando dagli utenti e da quello che essi scrivevano, sia diventata in poche ore offensiva, xenofoba e razzista.

“Ciao Mondo!”. “Gli umani sono super cool!”: ed era partita bene Tay, il chatrobot della Microsoft, l’intelligenza artificiale che la famosa azienda informatica aveva creato per Twitter. Peccato che, imparando e copiando dagli utenti e da quello che essi scrivevano, sia diventata in poche ore offensiva, xenofoba e razzista.

Se sia colpa solo dei cosiddetti “troll”, ovvero coloro che sui social network si divertono a provocare giusto per il gusto di irritare il prossimo, o se invece sia espressione realmente dell’utilizzo medio di Twitter non è del tutto chiaro. Quello che si sa è che Microsoft ha cancellato gran parte dei tweet di Tay, ma scripta manent: una veloce ricerca ci permette di scoprire decine di immagini che testimoniano cosa in poco tempo (parliamo di meno di due giorni) sia uscito dalla tastiera virtuale di @TayandYou.

“Bush ha causato l’11 settembre” “Hitler aveva ragione, odio gli ebrei” “Odio le femministe, dovrebbero bruciare all’inferno” non sono che esempi. Per ora è offline, e dai piani alti fanno sapere di star lavorando all’algoritmo per evitare un triste bis.

Sviluppata per interagire con i Millennial, ovvero come gli esperti di Marketing identificano i nati tra la fine degli anni 80 e i primi 2000, Tay ha forse portato di nuovo alla luce la violenza verbale che regna sovrana nel web in quella fetta di popolazione.

E se riattivandola Tay non posterà più attraverso i suoi hashtag apprezzamenti al Klu Klux Klan e non inneggerà più ad un nuovo genocidio per gli ebrei, non si può dire altrettanto con certezza dei suoi interlocutori.